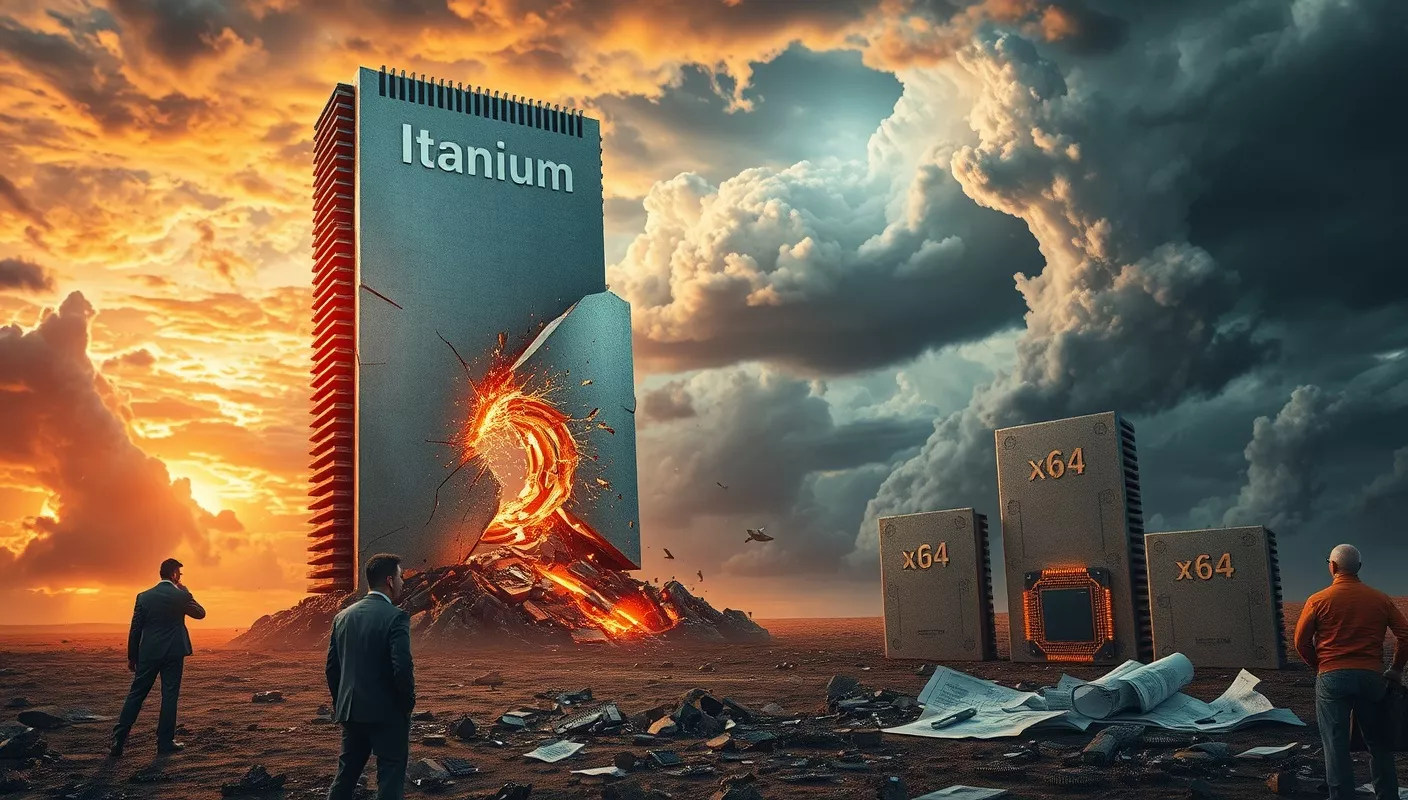

Warum Intel heute froh sein kann, dass Itanium scheiterte

Die Geschichte der Prozessorentwicklung ist geprägt von Innovationen, aber auch von Fehlschlägen. Einer der ambitioniertesten und zugleich umstrittensten Ansätze war Itanium, eine Architektur, die Intel in den späten 1990er Jahren gemeinsam mit Hewlett-Packard (HP) entwickelte. Der Gedanke hinter Itanium war revolutionär: Explicitly Parallel Instruction Computing (EPIC) sollte herkömmliche CPU-Designs ablösen und eine neue Ära der Rechenleistung einläuten. Doch das ambitionierte Projekt scheiterte – und rückblickend betrachtet war dies möglicherweise das Beste, was Intel und der IT-Branche passieren konnte.

Warum Intel heute froh sein kann, dass Itanium scheiterte

Es ist selten, dass ein Scheitern einen positiven Effekt hat, aber im Fall von Itanium kann Intel tatsächlich glücklich darüber sein, dass sich diese Architektur nicht durchgesetzt hat. Hätte Itanium die technologische Landschaft dominiert, wie ursprünglich von Intel geplant, stünde die heutige Welt der KI, des Cloud-Computings und der Big-Data-Analysen vor nahezu unüberwindbaren Hürden. Stattdessen hat sich x86-64 als Standard etabliert, und Intel sowie die gesamte IT-Branche profitieren davon in erheblichem Maße. Dieser Artikel beleuchtet, warum Itanium für die moderne Welt der Technologie völlig ungeeignet gewesen wäre und warum sein Scheitern letztlich ein Segen für Intel war.

Das Konzept von Itanium: Gut gemeint, schlecht gemacht

Die Itanium-Architektur war in vielerlei Hinsicht revolutionär. Sie basierte auf der Idee der Explicitly Parallel Instruction Computing (EPIC), bei der der Compiler statt der CPU die Hauptlast der Optimierung trägt. Während moderne CPUs dynamisch parallelisieren und optimieren, wurde bei Itanium alles auf den Compiler verlagert. Das Ziel war es, die Hardware zu vereinfachen und maximale Effizienz zu erreichen – zumindest in der Theorie.

In der Praxis stellte sich jedoch heraus, dass diese Architektur komplett unpraktikabel war:

- Extrem hohe Anforderungen an Compiler: Der Compiler musste alle Optimierungsentscheidungen im Voraus treffen, einschließlich der Instruktionsplanung, Parallelisierung und Speicherzugriffe. Das führte zu enormem Rechenaufwand und langen Kompilierungszeiten.

- Schlechte Leistung bei dynamischen Workloads: Moderne Anwendungen wie KI und Cloud-Services sind hochdynamisch und erfordern, dass CPUs zur Laufzeit Entscheidungen treffen können. Itaniums statischer Ansatz war für solche Workloads schlicht ungeeignet.

- Fehlende Energieeffizienz: Itanium-Prozessoren waren aufwendig zu bauen und ineffizient im Betrieb, besonders im Vergleich zu modernen Architekturen wie x86-64 oder ARM64.

Das Szenario: Was wäre, wenn Itanium ein Erfolg geworden wäre?

Hätte sich Itanium in der IT-Welt durchgesetzt, sähen wir heute eine vollkommen andere, weitaus rückständigere technologische Landschaft. Hier einige der katastrophalen Konsequenzen:

1. Der Compiler- und Entwicklungs-Albtraum

Bereits heute benötigen große Softwareprojekte wie Chromium enorm viele Ressourcen, um kompiliert zu werden. Ein moderner 16-Kern-Prozessor braucht 4+ Stunden, um Chromium mit PGO (Profile-Guided Optimization) zu bauen, und das auf einer hochoptimierten x86-Architektur.

Auf Itanium wären die Compiler-Anforderungen exponentiell gestiegen:

- Tagelange Kompilierungszeiten: Der Compiler müsste jede Instruktion analysieren und optimieren, was bei dynamischen Projekten wie Chromium nahezu unmöglich wäre.

- RAM-Bedarf im absurden Bereich: Für Projekte wie Chromium wäre ein Compiler auf Itanium mit Sicherheit auf 256 GB RAM oder mehr angewiesen – einfach, um die Datenstrukturen und Optimierungen im Speicher zu halten.

- Debugging wäre unerträglich: Jede kleine Änderung am Code würde enorme Rebuild-Zeiten nach sich ziehen, wodurch Entwicklungszyklen von Wochen oder Monaten entstehen könnten.

2. Ungeeignet für moderne Workloads

Die heutigen Workloads, die unsere technologische Welt antreiben, wären mit Itanium nicht realisierbar:

- KI (Künstliche Intelligenz): Moderne KI-Modelle wie GPT-3 oder AlphaFold basieren auf massiv parallelen Berechnungen, die dynamisch optimiert werden müssen. Itaniums statische Architektur könnte solche Anforderungen niemals erfüllen.

- Cloud-Computing: Dienste wie AWS oder Google Cloud basieren auf flexiblen, dynamischen Ressourcenmanagementsystemen. Virtualisierung, Containerisierung und schnelle Skalierbarkeit sind auf Itanium schlicht nicht umsetzbar.

- Big Data und Echtzeitanalysen: Systeme wie Apache Spark oder Hadoop erfordern schnelle, dynamische Hardware, um riesige Datenmengen in Echtzeit zu verarbeiten. Itanium wäre für solche Szenarien völlig ungeeignet.

3. Energieverbrauch und Hardwarekosten

Eine Welt voller Itanium-Prozessoren wäre auch aus energetischer und wirtschaftlicher Sicht ein Albtraum:

- Energieverbrauch: Die ineffiziente Architektur von Itanium würde Rechenzentren enorm viel Strom kosten, insbesondere für dynamische Workloads.

- Hardwarekosten: Die Herstellung und Wartung von Itanium-basierten Systemen wäre aufgrund der komplexen Architektur extrem teuer.

Der Vergleich: Warum x86-64, RISCV und ARM besser sind

Zum Glück hat sich die Welt für x86-64 (und zunehmend ARM64 sowie RISC-V) entschieden, Architekturen, die dynamisch arbeiten und flexibel anpassbar sind. Ihre Vorteile gegenüber Itanium sind eindeutig:

- Dynamische Optimierung: Moderne CPUs verwenden Technologien wie Out-of-Order Execution und Branch Prediction, um Instruktionen zur Laufzeit zu optimieren.

- Skalierbarkeit: Sowohl x86-64 als auch ARM64 können problemlos von kleinen Geräten bis hin zu Rechenzentren skaliert werden.

- Energieeffizienz: ARM64 und moderne x86-Prozessoren wie AMDs Zen-Architektur bieten extreme Leistung pro Watt – etwas, das Itanium nie erreichen konnte.

- Breite Unterstützung: Die gesamte Softwarewelt ist heute auf x86 und ARM optimiert, was eine weitaus größere Kompatibilität und Performance bietet.

Warum das Scheitern von Itanium ein Erfolg ist

Das Scheitern von Itanium war für Intel und die gesamte IT-Branche ein Segen. Hätte sich diese Architektur durchgesetzt, wären wir heute in einer technologischen Sackgasse:

- KI und Cloud wären nicht möglich: Die moderne Welt der Datenverarbeitung wäre mit Itanium nicht realisierbar.

- Energiekrise durch ineffiziente Systeme: Itanium-basierte Rechenzentren wären wahre Stromfresser.

- Innovation wäre ausgebremst: Langsame Compiler, unpraktikable Entwicklungszyklen und enorme Hardwarekosten hätten die Innovationsgeschwindigkeit drastisch reduziert.

Heute kann Intel froh sein, dass Itanium scheiterte. Es ermöglichte die Weiterentwicklung von x86 und den Aufstieg von ARM, die unsere technologische Welt in eine völlig neue Ära geführt haben. Itanium bleibt als Warnung bestehen, wie ein gutes Konzept in der Theorie in der Praxis zu einem Albtraum werden kann.